Alzheimer-Erkennung mit Deep Learning

Hier möchte ich einmal aus meiner hauptberuflichen Tätigkeit beim Deutschen Zentrum für Neurodegenerative Erkrankungen (DZNE) berichten. Dort arbeite ich seit einigen Jahren an künstlichen neuronalen Netzen zur Erkennung der Alzheimer-Krankheit auf MRT-Bildern. Dazu verwenden wir eine ausgefeilte Vorverarbeitung, die die Hirnscans vereinheitlicht und zwischen vielen Probanden vergleichbar macht. Darauf folgt noch ein zweiter Schritt zur Bereinigung von Intensitätsunterschieden bedingt durch Alter, Kopfgröße oder Feldstärke des MRT-Geräts. Dann kommt das künstliche neuronale Netz zu Anwendung, häufig nun auch mit dem englischen Titel Deep Learning in den Medien vertreten. Wir nutzen hier eine relativ reduzierte Variante mit verschiedenen Schichten, die so auch in verschiedenen Mustererkennungsanwendungen verwendet wird (z.B. Ziffernerkennung). Eine besondere Herausforderung stellt hier das Ausgangsbild im 3D-Format dar, was mit einer deutlich höheren Komplexität der zu erlernenden Merkmale führt. Deshalb werden die Trainingsbilder vorweg künstlich durch verschiedene Transformationen dupliziert. Dadurch können wir dem Algorithmus deutlich mehr Trainingsmaterial übergeben, was sich dann auch in einer verbesserten Erkennungsrate und robusteren Ergebnissen widerspiegelt.

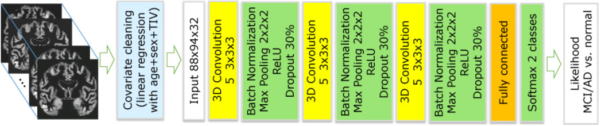

Über mehrere Schichten werden 3D-Bilder verarbeitet. In der ersten Schicht verringern wir den Einfluss des Alters oder der Kopfgröße auf das regionale Volumen der grauen Substanz. Dann folgen mehrere Faltungsoperationen (Convolution) zur Mustererkennung, Normalisierungsschritte und Zusammenfassung von Bildbereichen (Pooling) bis zur finalen Erkennung von veränderten Hirnbereichen (Fully connected). Das Modell gibt dann die Wahrscheinlichkeit für das Vorhandensein von Alzheimer-typischen Veränderungen aus (Likelihood).

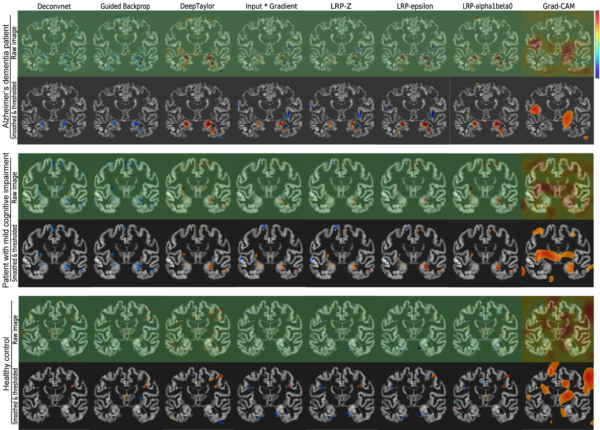

Nach dem Training des neuronalen Netzes habe ich eine neue Programmbibliothek iNNvestigate verwendet, die die Kollegen von der TU Berlin und dem Fraunhofer Heinrich Hertz Institut entwickelt haben. Damit ist es erstmals möglich, hochauflösende 3D Relevanzbilder aus dem Netz zu berechnen. Auf dem diesjährigen Workshop Bildverarbeitung für die Medizin präsentiere ich einen Vergleich von Visualisierungsalgorithmen.

Nach dem Training des neuronalen Netzes habe ich eine neue Programmbibliothek iNNvestigate verwendet, die die Kollegen von der TU Berlin und dem Fraunhofer Heinrich Hertz Institut entwickelt haben. Damit ist es erstmals möglich, hochauflösende 3D Relevanzbilder aus dem Netz zu berechnen. Auf dem diesjährigen Workshop Bildverarbeitung für die Medizin präsentiere ich einen Vergleich von Visualisierungsalgorithmen.

Obere Reihe: Patient mit Alzheimer-Demenz; mittlere Reihe: Patient mit leichter kognitiver Störung; unten: gesunder Proband. Einmal jeweils die Relevanzwerte im Rohformat und einmal geglättet und mit Schwellwert auf die wichtigsten Areale fokussiert.

Damit konnte ich einen interaktiven Prototypen für die Visualisierung von relevanten Hirnbereichen entwickeln. Hiermit erhält man nun sofort eine Einschätzung, ob der Proband für Alzheimer-erkrankt gehalten wird und welche Bereiche im MRT-Scan dafür sprechen. Dieser Prototyp soll zukünftig für weitere dementielle Erkrankungen erweitert und in Bezug auf den praktischen Nutzen für Radiologen evaluiert werden.

Der Nutzer kann interaktive durch die Schichten navigieren, den Schwellwert für die Intensität sowie minimale Clustergröße festlegen. Zur Lenkung der Aufmerksamkeit ist die Verteilung der wichtigsten Relevanzregionen über die Schichten in dem roten Diagramm dargestellt (mittig links). Darunter sieht man im blauen Histogramm die Verteilung der Größe der Cluster (unten links).